-

Más de 1.000 pacientes con hemofilia reciben una atención sanitaria multidisciplinar en Andalucía

La Consejería de Salud y Consumo, con motivo del Día Mundial de la Hemofilia, que se conmemora este 17 de abril, ha transmitido un mensaje de confianza y seguridad a los pacientes con esta enfermedad en el sistema sanitario público de Anddalucía, donde se asisten a más de 1.000 personas que sufren esta patologaía y…

-

Sărbătorește Ziua Cărții la Madrid – Știri din Madrid

Consiliul orașului Madrid se alătură sărbătoririi Zilei Cărții cu o programare extinsă în cartierele sale Târgurile de carte pentru veterani și altele care se nasc anul acesta se vor întâlni în weekendurile următoare Rețeaua Bibliotecilor Publice Municipale din Madrid se alătură sărbătorii cu diverse activități pentru toate publicurile Se apropie esențiala întâlnire anuală dintre librării,…

-

PSOE află că partenerul său și sprijinul guvernului Bildu nu condamnă ETA – Știri din Spania

Liderul Bildu și fostul membru ETA Arnaldo Otegui a prezis că ambarcațiunile de patrulare a Gărzii Civile vor înceta să mai circule în estuarul Bilbao. sau acostarea în porturile și golfurile din Țara Bascilor, pentru că locul lui va fi luat de către „Marina Națională a Euskadi”, națiunea independentă. Și acest anunț coincide cu o…

-

Navidul scoate la sorți o cutie cu vâsle de momeală – Cadouri și mostre gratuite – Știri de agrement

Crăciun Are un nou giveaway la îndemână și va oferi o cutie de umăr de momeală 100% iberică. Doriți să câștigați acest premiu pe care să îl împărtășiți la întâlnirile dvs.? Șunca Navidul Iberică Cebo se vindecă pe parcursul unui proces de peste 24 de luni, motiv pentru care capătă o aromă și o aromă…

-

Curiozitate istorică: Descoperirea unui schellet din epoca medievală într-un castel abandonat

Descoperirea unui schelet din epoca medievală într-un castel abandonat reprezintă un eveniment deosebit de interesant și captivant pentru pasionații de istorie și arheologie. Acest gen de descoperiri reprezintă o adevărată comoară pentru cercetătorii care vor să afle mai multe despre trecutul omenirii și despre viața din acele vremuri îndepărtate. Una dintre cele mai recente descoperiri…

-

¡Recrea esta misteriosa escena de “Detective Conan”! “Conan Edogawa” ahora es tridimensional con un sofá – El bono limitado incluye “Sleeping Kogoro” Acstar

¡Recrea esta misteriosa escena de “Detective Conan”! “Conan Edogawa” ahora es tridimensional con un sofá – El bono limitado incluye “Sleeping Kogoro” Acstar Contenido original en Inglés

-

Máquinas con mando a distancia para los trabajos de prevención de incendios y limpieza de montes

El cuidado y mantenimiento de los montes, así como la prevención de los incendios forestales pasa también por emplear una tecnología que permita el acceso a lugares particularmente abruptos y que garantice la seguridad de los trabajadores. La Consejería de Sostenibilidad, Medio Ambiente y Economía Azul ha adquirido ocho vehículos desbrozadores que se manejan con…

-

La hija de Luis Enrique está saliendo con la segunda selección española tras su ruptura con el Barcelona Ferran Torres

Fue tema de gran diversión cuando Sira Martínez, hija de Luis Enrique, empezó a salir Ferrán Torres. No solo porque muchos pueden imaginarse a Luis Enrique desempeñando bastante bien el papel de suegro intimidante, sino también porque en ese momento era el jefe de Torres en España. Según los informes, Martínez fue una de las…

-

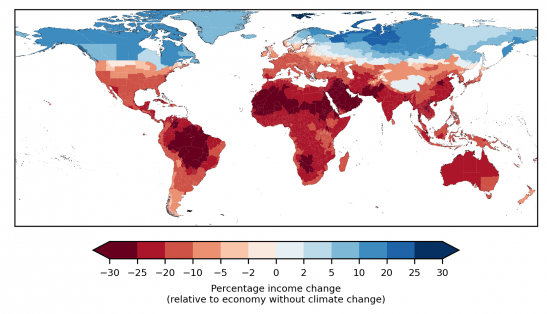

Venitul mediu global va scădea cu 19% din cauza schimbărilor climatice în 2050 – Știință Știri

Proiecțiile lui daune economice cauzate de schimbările climatice Ele sunt cruciale pentru adaptarea și procedurile de planificare ale entităților publice și private. Cu toate acestea, modelele sunt adesea limitate de natura variabilă a rezultatelor climatice pe termen lung. O echipă de cercetători, condusă de Leonie Wenz de la Potsdam Institute for Climate Impact Research (PIK)…

-

Inditex, mai generos cu directorii săi decât cu muncitorii săi, care au ieșit să protesteze – Știri din Spania

Multinaționala Inditex, cunoscută pentru brand-ul său emblematic Zara, a generat din nou titluri, dar de data aceasta nu doar pentru recordurile sale în rezultate financiare și pe bursă, ci și pentru suma mare pe care a alocat-o stimulentelor conducerii sale. directivă. Compania fondată de Amancio Ortega a distribuit aproape 15 milioane de euro în rândul…